Москва, Россия — 3 августа 2023 г.

Ученые из лаборатории исследований искусственного интеллекта (ИИ) Tinkoff Research открыли новый алгоритм для обучения ИИ. Новый метод, названный

Обучение искусственного интеллекта — процесс, требующий больших ресурсов: прежде всего, вычислительных мощностей, финансовых затрат и времени. Его оптимизация позволит ускорить развитие всех областей, в которых используются

Результаты исследования были признаны мировым научным сообществом и представлены на Международной конференции по машинному обучению (ICML)[2], которая в этом году прошла в

Суть открытия

Сегодня одно из наиболее перспективных видов обучения ИИ — обучение с подкреплением (RL)[3], вдохновленное процессами человеческого обучения и отличающееся высоким уровнем эффективности. RL позволяет роботам учиться методом проб и ошибок, адаптироваться в сложных средах и изменять поведение на ходу. Обучение с подкреплением может использоваться во всех сферах: от регулирования пробок на дорогах до рекомендаций в социальных сетях, которые предлагают пользователю контент, основанный на его предпочтениях.

Ранее считалось, что использование случайных нейросетей (алгоритмов для последовательного и автоматического принятия решений, RND) не подходит для

При использовании метода RND участвуют две нейросети — случайная и основная, которая пытается предсказать поведение первой. Важное свойство каждой нейросети — ее глубина: количество слоев, из которых она состоит. У основной сети не должно быть меньше слоев, чем у случайной, иначе она не сможет смоделировать ее поведение, что приведет к нестабильности или невозможности обучения. В Tinkoff Research обнаружили, что в предыдущих работах на тему использования случайных нейросетей в обучении с подкреплением размер случайной сети составлял четыре слоя, а размер основной — два.

Использование неправильных размеров сетей привело научное сообщество к ошибочному выводу, что метод RND не умеет дискриминировать (классифицировать) данные — отличать действия, которые были в датасете, от тех, что там не было. Исследователи из Tinkoff Research исправили глубины сетей, сделав их эквивалентными, и быстро обнаружили, что при таких настройках методу удается различать данные.

Следующим шагом стала оптимизация метода. Роботы научились приходить к эффективным решениям благодаря использованию механизма слияния, основанного на модуляции сигналов и их линейном отображении. В предыдущих работах на тему RND сигналы не подвергались дополнительной обработке.

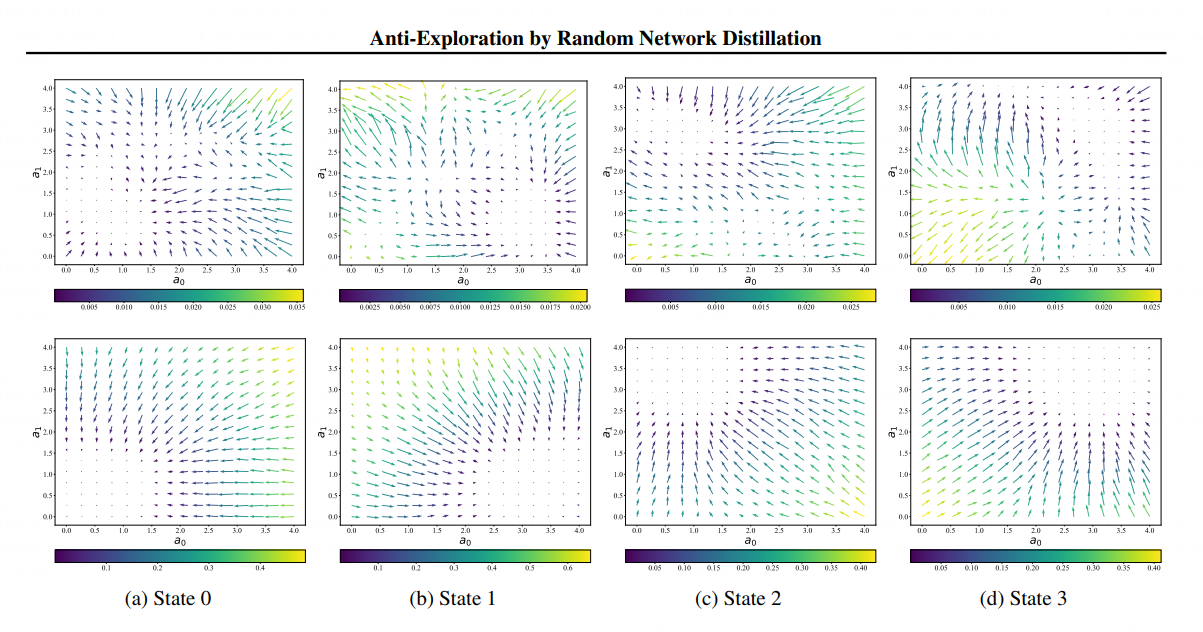

Визуализация принятия решения роботами, обученными с помощью разных алгоритмов. 4 рисунка сверху — предыдущие методы, основанные на RND, 4 рисунка снизу — метод

Метод

Лаборатория исследований ИИ Tinkoff Research

Tinkoff Research — это одна из немногих российских исследовательских групп, которая занимается научными исследованиями внутри компании, а не на базе некоммерческой организации.

Ученые из Tinkoff Research исследуют наиболее перспективные области ИИ: обработку естественного языка (NLP), компьютерное зрение (CV), обучение с подкреплением (RL) и рекомендательные системы (RecSys). По результатам экспериментов они пишут научные статьи для наиболее авторитетных научных конференций: NeurIPS, ICML, ACL, CVPR и других.

За два года существования команды более 13 статей были приняты на крупнейшие конференции и воркшопы в области ИИ. Научные работы Tinkoff Research цитируются учеными из университетов Беркли и Стэнфорда, а также исследовательского проекта Google по изучению искусственного интеллекта Google DeepMind.

Команда курирует исследовательскую лабораторию Тинькофф на базе МФТИ и помогает талантливым студентам совершать научные открытия.

[1] SAC — Soft Actor Critic (мягкий

[2] International Conference on Machine Learning (ICML) — международная конференция по машинному обучению.

[3]Reinforcement learning (RL) — обучение с подкреплением.

Похожие новости